: Intel Ultra 7 155H

: CPU分數 67

: GPU分數 413

: NPU分數 282

: 嗯....這NPU看起來沒比較厲害?

: 所以我的疑問就是:

: 1. NPU 表現還不如 GPU, 這也許可以理解為最佳化還沒到位,

: 不過即使未來能小贏, 為什麼不拿去做GPU就算了, 還可以增加3D性能。

npu/matrix/tensor其實不能增加傳統的3d性能。增加的是dlss/ray tracing的性能。

但這是個好問題,現在的情況,npu(matrix)如果併入gpu或cpu其實是更好的選擇。

: 2. NPU 能執行通用計算嗎? 如果可以, NPU 只是神經網路運算特化但這是個好問題,現在的情況,npu(matrix)如果併入gpu或cpu其實是更好的選擇。

: 的 GPU?

npu是matrix(systolic array)特異化的超簡易cpu。不適合通用計算

: 3. 如何調用 NPU? 是視為 OpenCL / DirectML 裝置?: 還是又整出新的方法跟API了?

: 又或只是在GPU下的子集? (調用核顯運算時指示調用NPU?)

目前就是另一個黑盒子運算機,不需要opencl/directml,可以直接從程式使用,如果os有開放出來。

gpu/avx,是simd,是1d array的運算

npu/amx/tensor是systolic array,是2d array的運算。

simd也可以matrix運算,但比較沒有效率,因為要一直切換資料。

gpu+tensor/cpu+amx,就是把傳統的1d暫存器擴張到2d暫存器(systolic array),把切換資料的時間省下來。效率可以2x~8x或更多。

現在影像的ai運用,npu是足夠的,這是當初設計npu的目的。就算是現在很紅的diffusion model,NPU也是很適合的,因為不需要即時反應。

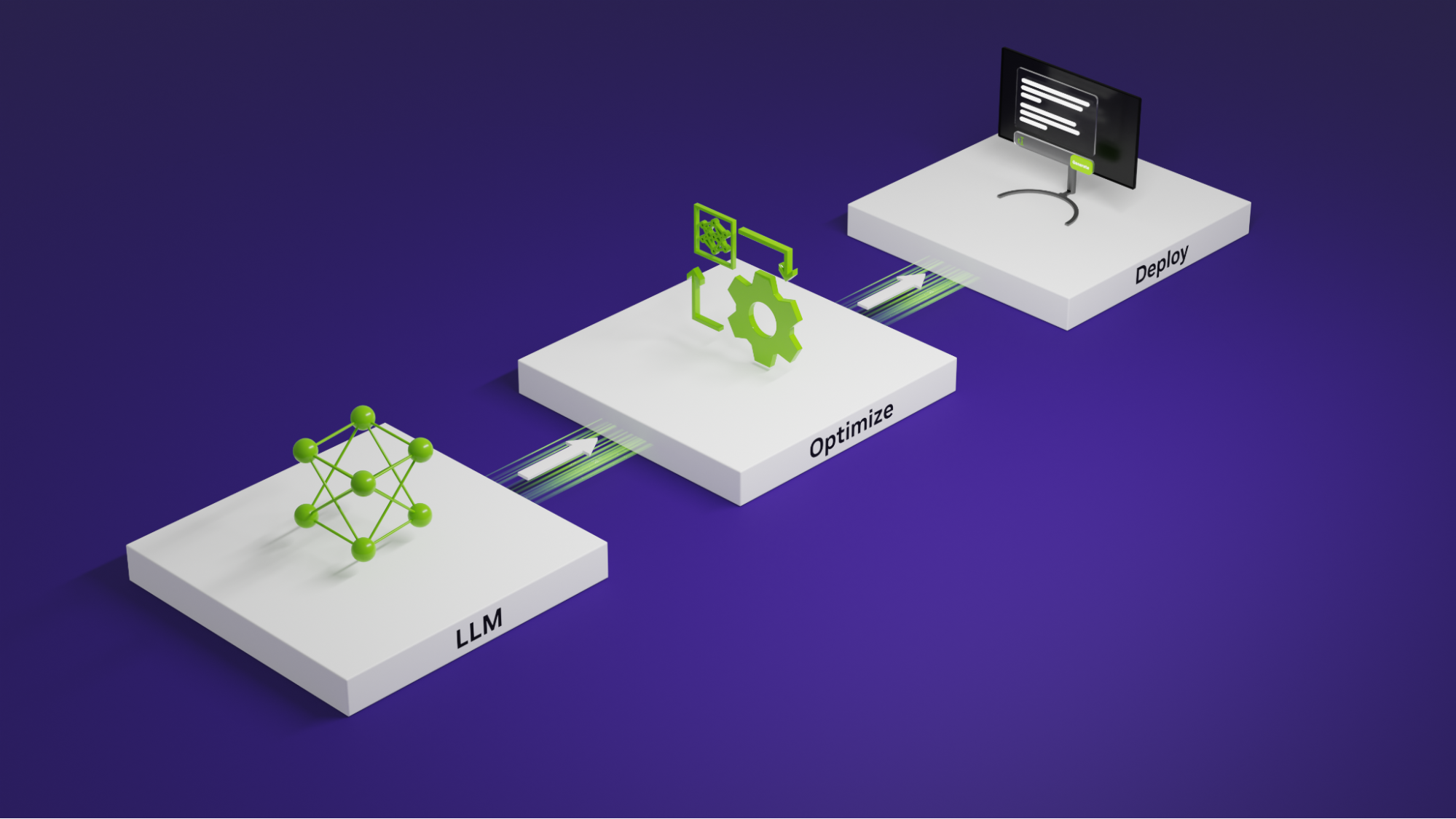

現在的問題是,LLM(Large language Model),現在ai炒作其實就是講這個。

LLM吃記憶體吃記憶體頻寬吃運算能力。只用npu來暴力運算是行不通的。

N家的inference optimization文章

https://developer.nvidia.com/blog/mastering-llm-techniques-inference-optimization/gpu/avx,是simd,是1d array的運算

npu/amx/tensor是systolic array,是2d array的運算。

simd也可以matrix運算,但比較沒有效率,因為要一直切換資料。

gpu+tensor/cpu+amx,就是把傳統的1d暫存器擴張到2d暫存器(systolic array),把切換資料的時間省下來。效率可以2x~8x或更多。

現在影像的ai運用,npu是足夠的,這是當初設計npu的目的。就算是現在很紅的diffusion model,NPU也是很適合的,因為不需要即時反應。

現在的問題是,LLM(Large language Model),現在ai炒作其實就是講這個。

LLM吃記憶體吃記憶體頻寬吃運算能力。只用npu來暴力運算是行不通的。

N家的inference optimization文章

基本上,LLM的資料其實很鬆散,但很龐大,所以必須要想辦法做各種記憶體的規劃跟重組。

一個壓縮過,重組記憶體排列方法的Model,可以有10x以上的效能提昇,以後可能可以有100x的 提昇。

一個很有趣的例子,intel剛買下的Numenta

他把Sparse的matrix重組成Compressed Sparse Row,然後運用cpu能力去解開到AMX再來運算,就達到10x~20x的提昇。

這個再加各種caching跟attention的優化,100x提昇是很有可能達到的。

趨勢來講,ai還在演變,cpu+amx或gpu+tensor還是會是短期發展的趨勢。

--