https://simonwillison.net/2023/Mar/11/llama/

https://simonwillison.net/2023/Mar/13/alpaca/

Simon Willison提到,很快大家都會有自己的ai助手。

看時間軸:

24th February 2023: LLaMA is announced, starts being shared with academic partners:

https://research.facebook.com/publications/llama-open-and-efficient-foundation-language-models/

2nd March: Someone posts a PR with a BitTorrent link to the models:

https://github.com/facebookresearch/llama/pull/73

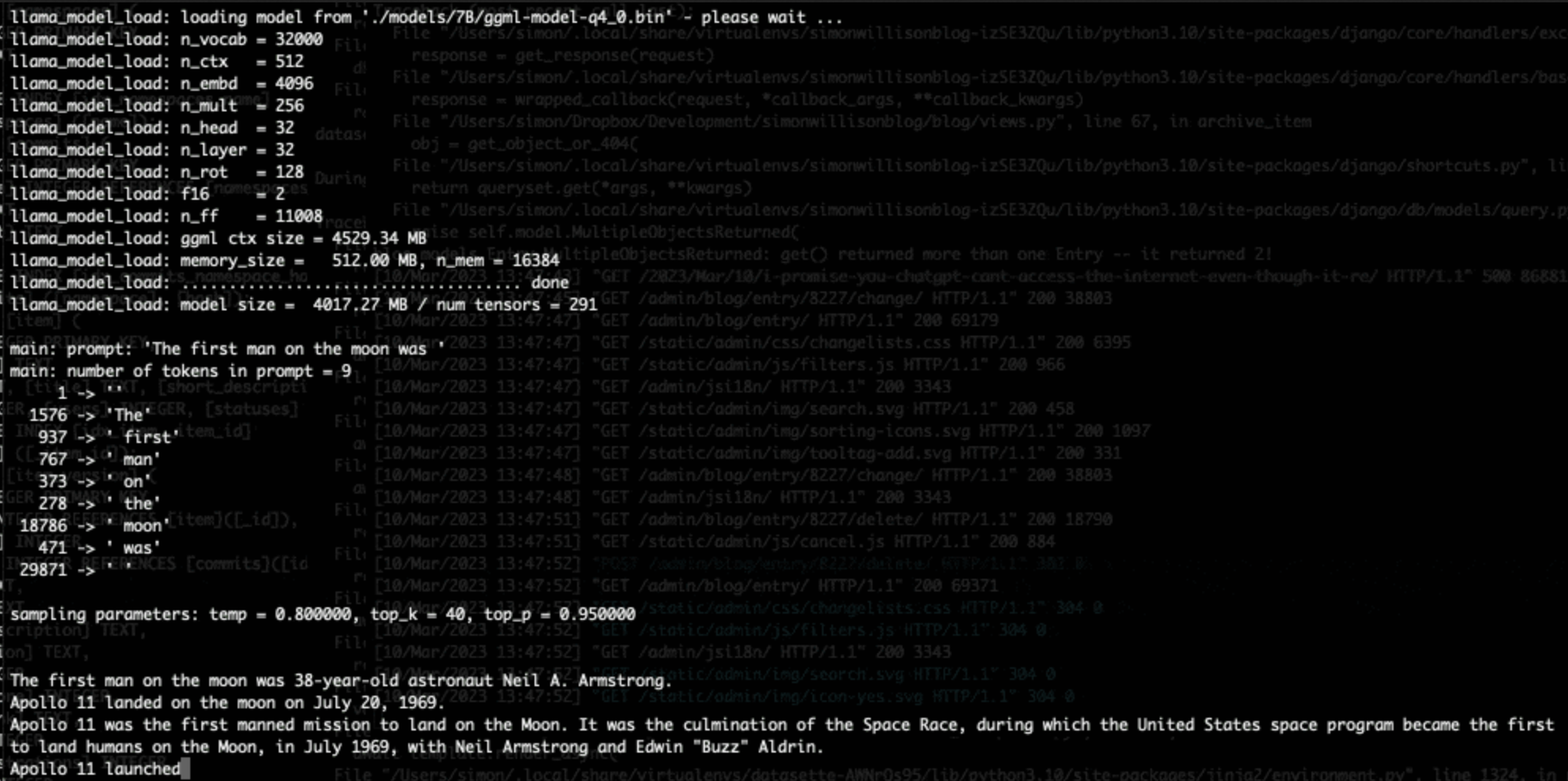

10th March: First commit to llama.cpp by Georgi Gerganov:

https://github.com/ggerganov/llama.cpp

11th March: llama.cpp now runs the 7B model on a 4GB RaspberryPi:

https://twitter.com/miolini/status/1634982361757790209

12th March: npx dalai llama: https://cocktailpeanut.github.io/dalai/

13th March (today): llama.cpp on a Pixel 6 phone:

https://twitter.com/thiteanish/status/1635188333705043969

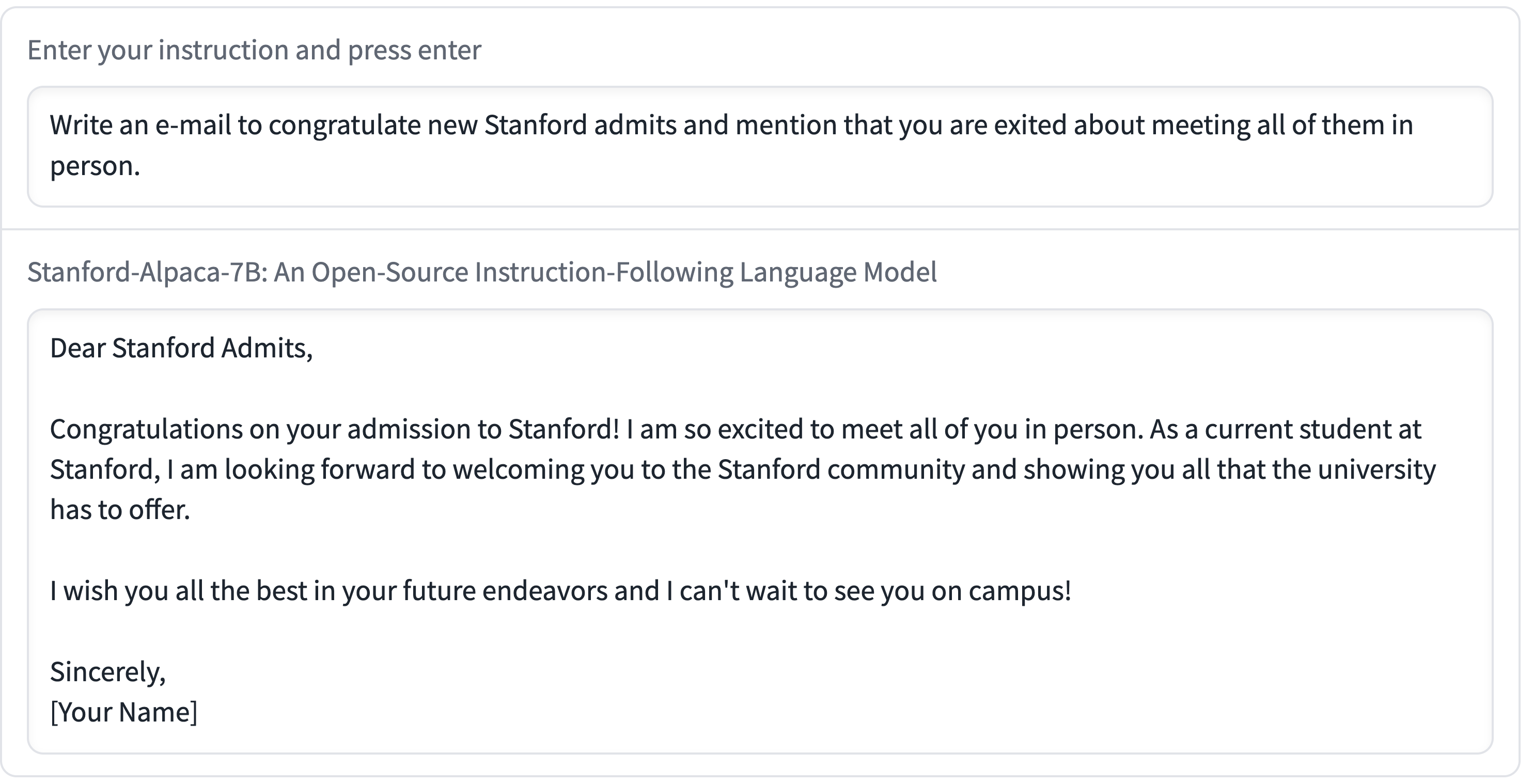

And now, Alpaca.

https://crfm.stanford.edu/2023/03/13/alpaca.html

------------------------------------------

詳細想法與內容就請看simon willison的部落格。

我是蠻認同這想法的,LLM(Large Language Model)很快就會普及。

https://cocktailpeanut.github.io/dalai/#/

自動安裝的script都出了。LLaMA的Inference在現代多核CPU跑是可行的,現在優化速度也很快。

離ChatGPT,GPT4還有一段距離,但很夠用了,而且整個網路一起發展,可能很快就追上也不一定。我雖然最近超忙,但都想找時間看能不能移植到OpenCL。

我覺得LLM最大的好處是summerize(總結)

例如之前討論手刻Make的問題。

Make是偶而一用,真的容易忘記指令跟功能,也就不容易發現問題。

LLM在這就很適合幫忙,把make檔給它,解釋總結,很快就能發現問題,就不須要找很難找到的Make專家。

雖然LLM容易"hallucinate"但用LLM寫個簡單的Make檔案當個開頭也很好。

Code看不懂,用太多不明functions?LLM來幫忙。

ffmpeg參數太多太複雜?LLM寫給你。

這是當年google橫空出世讓網路好用起來。再一次大感動。大家真的可以好好追蹤這個發展。可以自己控制的LLM,可以發展的功能太多了。

--