原文標題:

Ilya離開OpenAI內部曝光:奧特曼砍他團隊算力,優先搞產品賺錢

原文連結:

https://www.qbitai.com/2024/05/143688.html

發布時間:

2024-05-18 13:11:58

記者署名:

衡宇白交

原文內容:

連發13條推文!

OpenAI超級對齊負責人 Jan Leike ,也就是剛剛追隨Ilya離開公司的那位,自曝離職的

真正原因,以及更多內幕。

一來算力不夠用 ,承諾給超級對齊團隊的20%缺斤少兩,導致團隊逆流而行,但也越來越

困難。

二來安全不重視 ,對AGI的安全治理問題,優先順序不如推出「閃亮的產品」。

緊接著,更多的八卦被其他人挖出來。

例如OpenAI離職成員都要簽一份協議, 保證離職後不在外說OpenAI壞話 ,不簽的話視為

自動放棄公司股份。

但仍有拒不簽署的硬骨頭出來放猛料(笑死),說核心領導階層對安全問題優先順序的分

歧由來已久。

去年宮鬥至今,兩派的觀念衝突到達了臨界點,這才看上去頗為體面地崩了。

因此,儘管奧特曼已經派了共同創辦人來接手超級對齊團隊,但仍舊不被外界看好。

衝在最一線的推特網友們感謝Jan有勇氣說出這個驚人大瓜,並感嘆:

我勒個去,看來OpenAI真的不太注重這個安全性!

不過回過頭來,如今執掌OpenAI的奧特曼這邊,暫時還坐得住。

他站出來感謝了Jan對OpenAI超級對齊和安全方面的貢獻,表示Jan離開,他其實很難過、

很捨不得。

當然了,重點其實是這句話:

等著,過兩天我會發一篇比這更長的推文 。

承諾的20%算力居然有畫大餅成分

從去年OpenAI宮鬥到現在,靈魂人物、前首席科學家Ilya幾乎不再公開露面、公開發聲。

在他公開宣稱離職前,就已經眾說紛紜。 很多人認為Ilya看到了一些可怕的事情,例如

可能毀滅人類的AI系統啥的。

△網友:我每天醒來第一件事就是想Ilya看到了啥

這次Jan算是攤開了說,核心原因是技術派和市場派對安全的優先等級產生了不同看法。

分歧很嚴重,目前後果嘛……大家也都看到了。

根據Vox報道,熟悉OpenAI的消息人士透露, 更注重安全的員工已經對奧特曼失去了信

心 ,「這是一個信任一點一點崩潰的過程」。

但如你所見,在公開平台和場合,沒有太多離職員工願意公開談論此事。

一部分原因是OpenAI一直以來,都有 讓員工簽署帶有非貶低協議的離職協議的傳統。 如

果拒絕簽署,就等於放棄了先前拿到的OpenAI的選擇權, 這意味著出來說話的員工可能

會損失一筆巨款。

然而,多米諾骨牌還是一張接一張的倒下了——

Ilya的辭職加劇了OpenAI近期的離職潮。

緊接著宣布離職的,除了超級對齊團隊負責人Jan以外,目前有至少五個安全團隊成員離

職。

其中還有個沒簽署非貶低協議的硬骨頭,Daniel Kokotajlo(以下簡稱DK哥)。

△去年DK哥寫道,他認為AI發生生存災難的可能性為70%

DK哥在2022年加入OpenAI,在治理團隊工作,主要工作內容是引導OpenAI安全部署AI。

但他也在近期辭職了,並且對外接受了採訪:

OpenAI正在訓練更強大的AI系統,目標是最終全面超越人類智慧。

這可能是人類有史以來發生過的最好的事情,但如果我們不小心行事,也可能是最糟

糕的事情。

DK哥闡述,當年,他加入OpenAI,滿懷對安全治理的報復與希望,期望OpenAI越靠近AGI

能越負責任。 但團隊中 許多人 慢慢意識到,OpenAI不會這樣了。

「逐漸對OpenAO領導層以及他們負責地處理AGI的能力失去了信心」,這就是DK哥辭職的

原因。

對未來AGI安全工作的失望,是Ilya加劇的離職潮中眾人離開的一部分原因。

還有一部分原因,是 超級對齊團隊,恐怕沒有外界想像的那樣能資源充沛地進行研究。

即便超級對齊團隊滿載工作,團隊也只能獲得OpenAI承諾的20%的算力。

而且團隊的一些請求經常被拒絕。

當然是因為算力資源對AI公司來說重要至極,每一點都要合理分配;也因為超級對齊團隊

的工作是「解決如果公司成功建構AGI,實際上會出現不同類型的安全問題」。

換句話說,超級對齊團隊對應的是OpenAI需要面對的未來的安全問題——劃重點,是未來

的、不知是否會出現的。

截至發稿,奧特曼還沒有發出他那篇「(比Jan爆料內幕的)更長的推文」。

但他簡單提到,Jan對安全問題的擔憂是對的, “我們還有很多事情要做;我們也致力於

這樣做。”

就這一點,大夥兒可以先辦個小板凳等等,到時候咱一起第一時間吃瓜。

綜上,現在超級對齊團隊走了好些人,尤其是Ilya和Jan的離職,讓這個風雨中的團隊面

臨群龍無首的窘況。

後續安排,是 共同創辦人John Schulma來接手 ,但不再有專門的團隊。

新的超級對齊團隊將是聯繫更鬆散的小組,成員分佈在整個公司的各個部門,OpenAI發言

人將其描述為「更深入地整合」。

這一點也為外界所質疑,因為 John的原本全職工作是確保目前的OpenAI產品的安全問題

。

不知道突然多了份責任後,John能不能忙得過來,好好領導關注現在和關注未來安全問題

的兩個團隊?

Ilya-Altman之爭

如果把時間陣線拉長, 其實今天的分崩離析是OpenAI「宮鬥」Ilya-Altman之爭的續集。

時間回溯到去年11月,當時Ilya還在,他與OpenAI董事會合作試圖解僱掉奧特曼。

當時給的理由是,他在溝通上不夠真誠。 換言之,我們不信任他。

但最終結果顯而易見,奧特曼帶著他的「盟友」威脅加入微軟,結果董事會屈服,罷免行

動失敗。 Ilya離開董事會。 而奧特曼這邊,選擇了對他更有利的成員加入董事會。

在這之後,Ilya就再也社交平台上消失了,直到前幾天官宣離職。 而且據說,已經大約6

個月沒有出現在OpenAI辦公室了。

當時他還留下一則耐人尋味的推文,但很快就刪除了。

在過去的一個月裡,我學到了許多教訓。 其中一個教訓是,「在士氣提高之前,毆

打會一直持續下去」這句話比它應有的含義更經常適用。

但據內部人士透露, Ilya一直遠端共同領導超級對齊團隊 。

而在奧特曼這邊,員工們對他最大的指控就是言行不一,例如他聲稱自己想優先考慮安全

,但他的行為卻很矛盾。

除了原本承諾的運算資源沒有給到外。 還有像前陣子找沙烏地阿拉伯等募款來造芯。

那些注重安全的員工懵了。

如果他真的關心以盡可能安全的方式建構和部署人工智慧,那麼就不會這麼瘋狂地累積晶

片,來加速技術的發展?

更早之前,OpenAI也從一家奧特曼投資的一家新創公司訂購晶片。 金額高達5,100萬美元

(約3.6億元)。

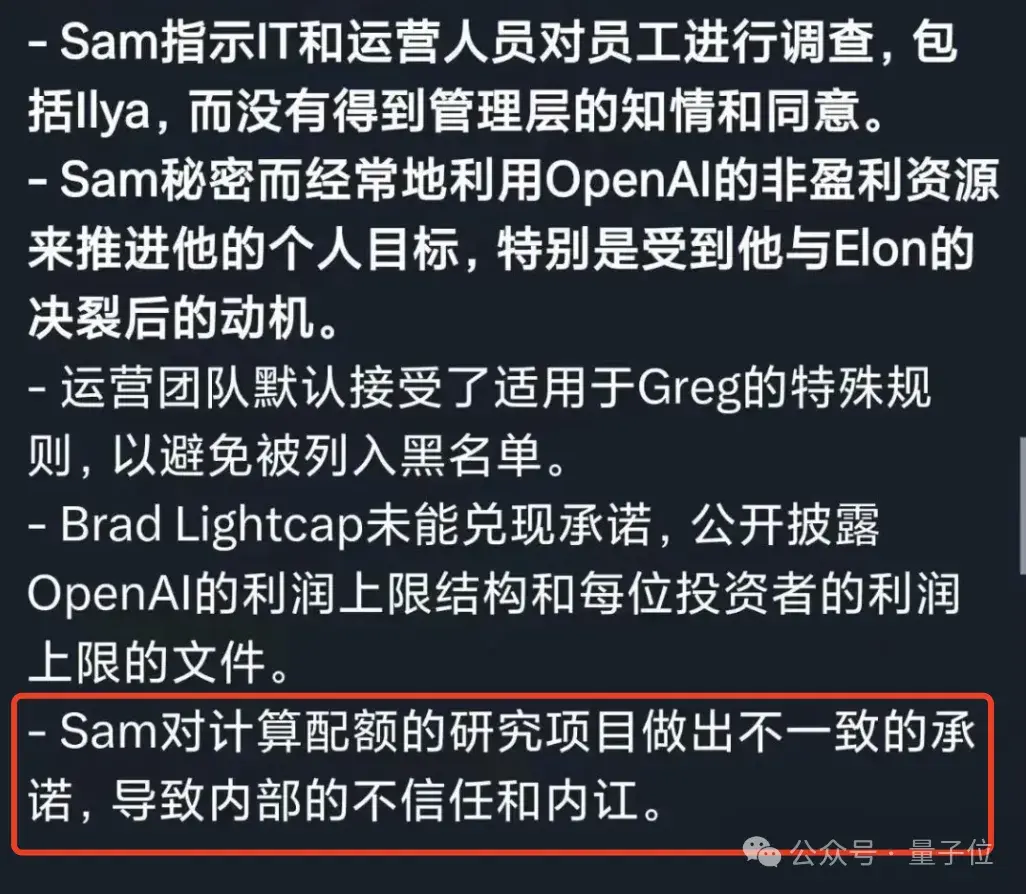

而當時宮鬥那幾天OpenAI前員工的檢舉信中,對於奧特曼的描述似乎也再一次印證。

https://tinyurl.com/2s4b42rm

也正因這樣 從頭到尾「言行不一」 的操作,讓員工們逐漸對OpenAI以及奧特曼失去信心

。

Ilya是這樣,Jan Laike是這樣,超級對齊團隊也是這樣。

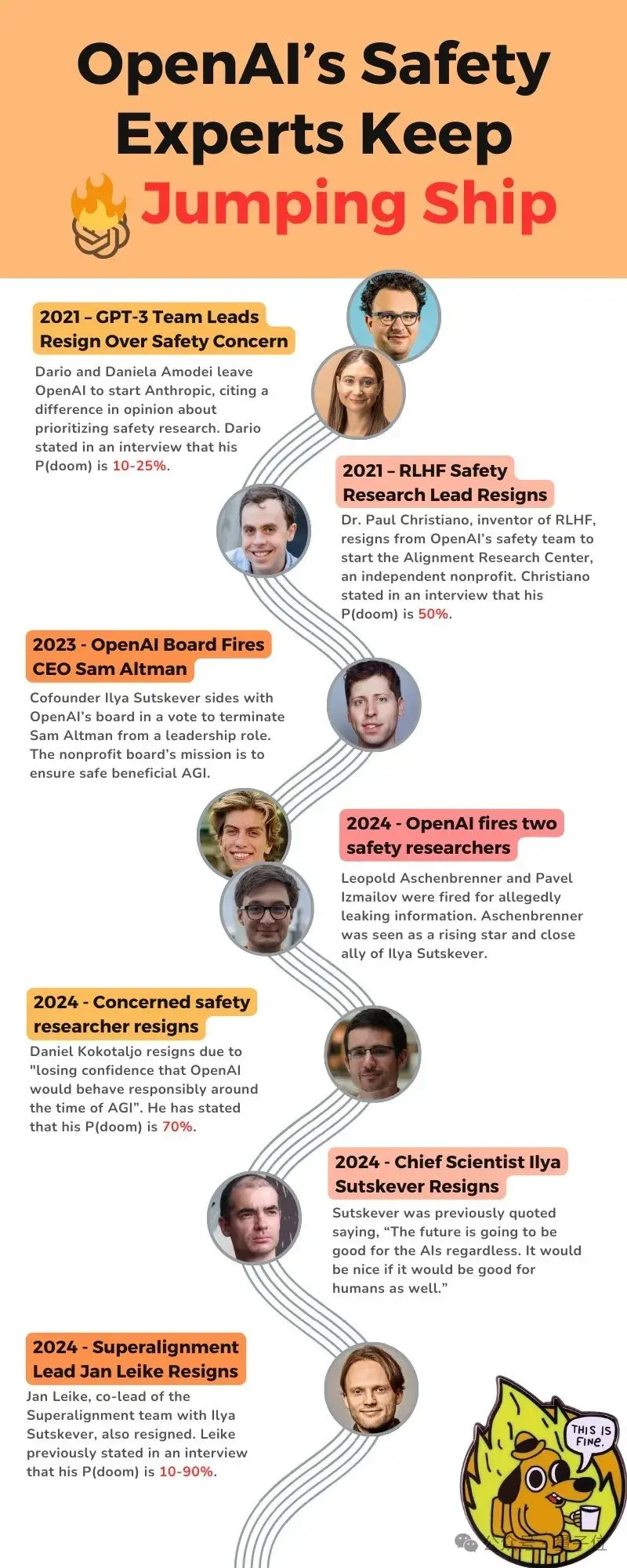

有貼心的網友整理出這幾年年間,發生的相關事情的重要節點-先來個貼心提示,下文提

到的 P(doom) ,指「AI引發世界末日場景的可能性」。

2021年,GPT-3團隊負責人因「安全」問題離開OpenAI,創立Anthropic;其中一位認

為P(doom)為10-25%;

2021年,RLHF安全研究負責人離職,P(doom)為50%;

2023年,OpenAI董事會解僱奧特曼;

2024年,OpenAI解僱兩位安全研究員;

2024年,一位特別關注安全的OpenAI研究員離職,他認為P(doom)已經在70%。

2024 年,伊利亞和簡·萊克退休。

https://tinyurl.com/vcw877d3

技術派還是市場派?

大模型發展至今,「如何實現AGI?」其實可歸結為兩條路線。

技術學派 希望技術成熟可控再應用; 市場派 則認為邊開放邊應用「漸進式」走到終點

。

這也是Ilya-Altman之爭的根本分歧,即OpenAI的使命:

是專注於AGI和超對齊,還是專注於擴展ChatGPT服務?

ChatGPT服務規模越大,代表所需的計算量越大;這也會佔用AGI安全研究的時間。

如果OpenAI是個致力於研究的非營利組織,他們應該將更多時間花在超級對齊上。

而從OpenAI對外的一些措施來看,結果顯然不是, 他們只是想要在大模型這個競爭中拔

得頭籌,為企業和消費者提供更多的服務 。

這在Ilya看來,這是件非常危險的事。 即便我們不清楚隨著規模的擴大會發生什麼,但

在Ilya看來,最好的辦法就是安全第一 。

開放和透明,這樣我們人類才能確保安全地建構AGI,而不是以某種隱密的方式。

但在奧特曼帶領之下OpenAI,似乎既不追求開源,也不追求超級對齊。 相反,它一

心只想朝著AGI 的方向狂奔,同時試圖建立一條護城河。

那麼最後AI科學家Ilya的選擇正確,還是矽谷商人奧特曼能走到最後呢?

現在還無從得知。 但至少OpenAI現在面臨關鍵抉擇。

有業內人士總結了兩個關鍵訊號,

一個 是ChatGPT是OpenAI主要收入,如果沒有更好的模型支撐,就不會免費向所有人提供

GPT-4;

另一個 則是如果離職的團隊成員(Jan、Ilya 等)不擔心很快會有更強大的功能,他們

就不會關心對齊的問題……如果AI停留在這個水平上,基本上也無所謂。

但OpenAI的根本矛盾沒有解決,一邊是盜火一樣的AI科學家對負責任發展AGI的憂慮,另

一邊則是矽谷市場派對於用商業化方式推動技術可持續的急迫。

雙方已經不可調和,科學派正在完全出局OpenAI,而外界至今也不知道,GPT究竟到哪一

步了?

迫切想要知道這個問題答案的吃瓜群眾都有點累了。

一種無力感湧上心頭,就像Ilya的老師、圖靈獎三巨頭之一Hinton說的:

我老了,我擔憂,但我無能為力了。

參考連結:

[1]https://www.vox.com/future-perfect/2024/5/17/24158403/openai-resignations-ai-safety-ilya-sutskever-jan-leike-artificial-intelligence

[2]https://x.com/janleike/status/1791498174659715494

[3]https://twitter.com/sama/status/1791543264090472660

心得/評論:

奧特曼違背防止人工智慧威脅人類的承諾 這導致安全團隊一直有人辭職

OpenAI會重蹈微軟和谷歌的覆轍 走向沒落嗎??

--