原文標題:

NVIDIA 推出個人 AI 聊天機器人 Chat With RTX 開放下載

原文連結:

https://reurl.cc/zlOepV

發布時間:

2024-02-14

記者署名:

SINCHEN

原文內容:

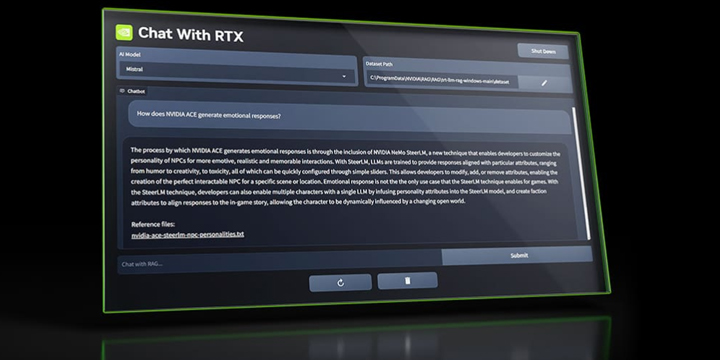

聊天機器人在各種領域中被廣泛使用,並且不少採用 NVIDIA GPU 的雲端伺服器提供服務

,但對於個人的敏感資料或者企業內部使用的狀況下,NVIDIA 推出 Chat with RTX 基於

本機的 RTX GPU 提供生成 AI 的聊天機器人服務。

Chat with RTX 採用檢索增強生成(Retrieval-Augmented Generation, RAG)、NVIDIA

TensorRT-LLM 軟體與 NVIDIA RTX 加速的本地端生成 AI,玩家可依據本地的資料連結至

開源的大型語言模型庫:Mistral、Llama 2,達到快速的查詢並獲得相關答案。

此外,Chat with RTX 工具支援著 .txt、.pdf、.doc、.docx 與 .xml 等文檔格式,能

將這些本地資料加入資料庫中,並且可加入 YouTube 影片、播放清單,讓聊天機器人可

根據喜愛的影片清單提供相關的整理資訊。

Chat with RTX 基於 PC 或者工作站電腦提供本地快速的生成 AI 聊天互動功能,使用者

的資料只會儲存在本地端的資料庫中,只要使用 GeForce RTX 30、RTX 40 系列 GPU 並

有著 8GB VRAM 以上的規格,在 Windows 10、11 等作業系統都可運行。

Chat with RTX 工具基於 TensorRT-LLM RAG 開發人員參考專案所建立並於 GitHub 中開

源釋出,開發者可依據此專案自行研發自有的 RAG 應用程式,並採用 RTX 加速的

TensorRT-LLM 語言模型。

Chat With RTX 下載:nvidia.com/en-us/ai-on-rtx/chat-with-rtx-generative-ai/

安裝完畢後 Chat with RTX 必須要指定文件、資料,才能依據這些資料透過 AI 模型生

成相關的對話,像是我指定有關於 RTX 40 Super 的資料後,就可以詢問關於 NVIDIA、

RTX 40 等問題。

換句話說若個人或企業的資料夠龐大時,可讓 Chat with RTX 的 AI 模型有著更好的資

料比對產生出關連度更高的結果;有興趣的玩家不妨下載安裝並提供資料,如此一來個人

的本地端生成 AI 聊天機器人就開始上工囉。

心得/評論:

已經有很多部落客對此有評論了

1. 整個下載包預計35G 非常大 要先把硬碟空間清出來

只支援RTX30或40系列顯卡 而且至少要8G VRAM

2. 及時運行速度很快 而且採用RAG可以很快校正答案

3. 跟GPT一樣 有些答案根本是胡扯 所以使用者還是要自己小心

感覺NV想給PC產業做個示範

以前有搭載GTX1050以上的 才叫做 Gaming PC,

現在刀客直接示範甚麼叫做 AI PC

先讓使用者有感覺

然後各大PC品牌就會自己放入符合規範的產品

--