看了板上的一些AI組機文,實在有點話想拿出來聊聊。

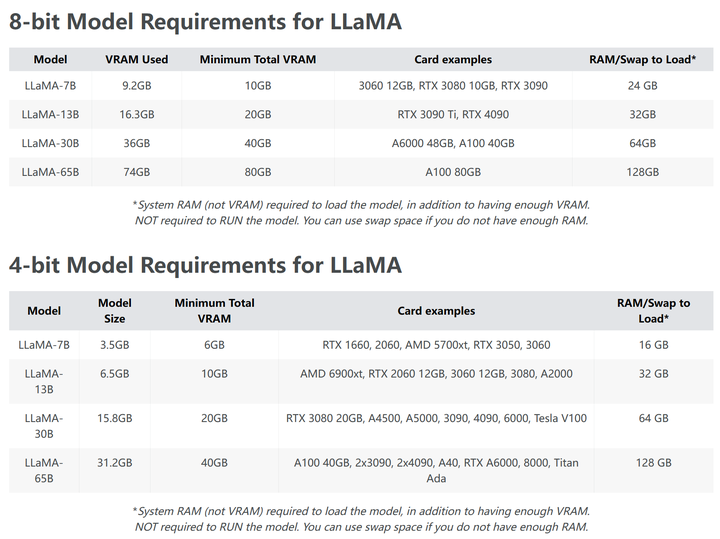

比較常提到的繪圖大家應該都知道,現在建議就是3060 12G,VRAM稱王,

其他選擇就是4070(Ti) 12G / 3090 24G / 4090 24G,4080 16G CP值太差...之類。

不過我真的強烈建議還弄的到二手3090就去弄、預算有個80K拿4090比較不會後悔。

為什麼呢?

不知道板上關注生成式語言模型(ex:ChatGPT)的人多不多,

GPT現在沒有開源,使用文字生成來做應用(串API)是逐字計費,

所以目前有一些仿GPT、甚至借助GPT訓練的開源語言模型正在發展中。

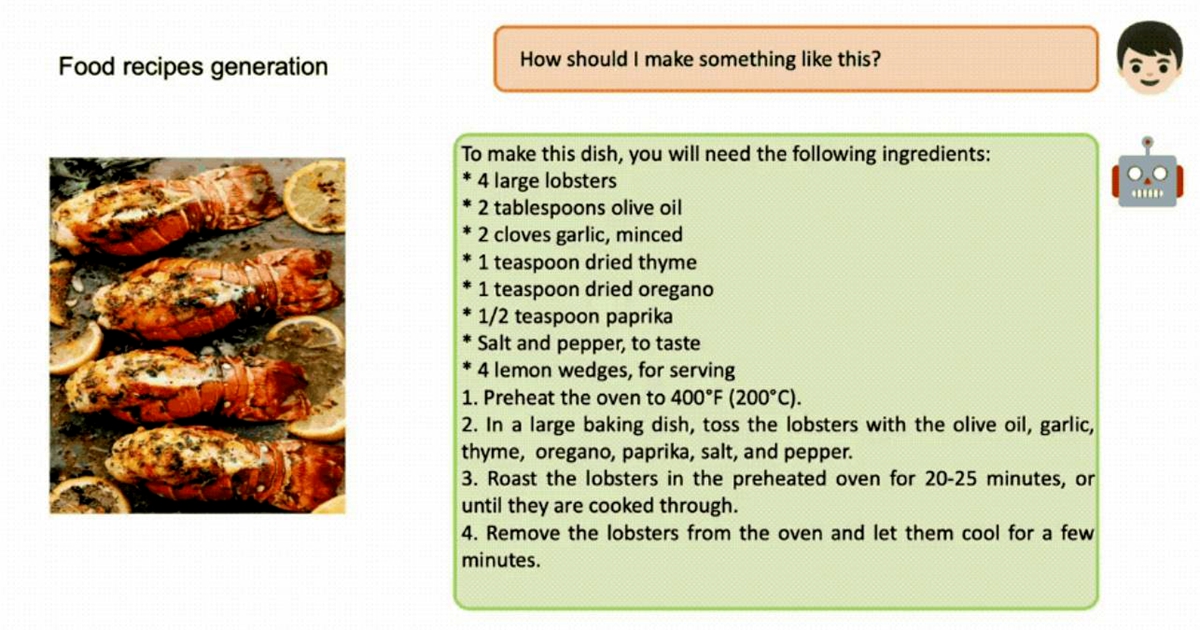

參考這幾天很紅的

GPT-4識圖功能不開放,MiniGPT-4搶先開放試用!OpenAI有的它都有

https://www.techbang.com/posts/105663

"並且團隊正在準備一個更羽量級的版本,部署起來只需要23GB的VRAM。 也就是消費級顯

示卡中擁有24GB VRAM的3090或4090就可以在本地端執行了。 "

Stable Diffusion團隊剛發布的StableLM

https://github.com/Stability-AI/StableLM/issues/17

以及其他語言模型

https://zhuanlan.zhihu.com/p/615199206

至少在這部分24G VRAM很可能會是標配。

一點淺見,感謝電蝦板在我要組跑AI用的電腦時給了很多建議,拿出來分享一下。

也留篇文讓人有機會爬。

--

AI_Art AI藝術與創作板 歡迎各方前來討論AIGC創作與相關議題!

AI情報屋營業中

噗浪:https://www.plurk.com/Zaious

IG :https://www.instagram.com/zaious.design/

日曆:https://zaious.notion.site/zaious/22c0024eceed4bdc88588b8db41e6ec4

--